¿Qué es la Tokenización de Datos y Cómo Protege su Información Sensible?

Nov 20, 2024

El entorno moderno, saturado de información, aumenta el peligro del mal uso de esta información, cuya prevención se ha convertido en uno de los principales desafíos para las personas del siglo XXI. Hoy en día, ninguna empresa puede funcionar sin bases de datos; por lo tanto, garantizar la seguridad y protección de esta información se ha convertido en la tarea de cualquier organización responsable.

Aquí es donde la tokenización de datos emerge como un poderoso mecanismo de defensa. Profundicemos en qué es la tokenización de datos, cómo funciona y cómo fortalece la seguridad de la información en comparación con los métodos tradicionales.

Puntos Clave

- La tokenización de datos es un proceso de seguridad avanzado que convierte información sensible en tokens sin significado, protegiendo la información sensible del acceso no autorizado.

- A diferencia de la encriptación, la tokenización no requiere claves de desencriptación. En su lugar, genera un valor de token aleatorio que se asigna a la información sensible dentro del sistema de tokenización.

- La tokenización protege información sensible como números de tarjetas de crédito, números de Seguro Social e Información de Identificación Personal.

- Esta solución puede implementarse en diversas aplicaciones, incluido el procesamiento de pagos, el análisis de datos y la gestión de datos de clientes.

La Idea de la Tokenización de Datos

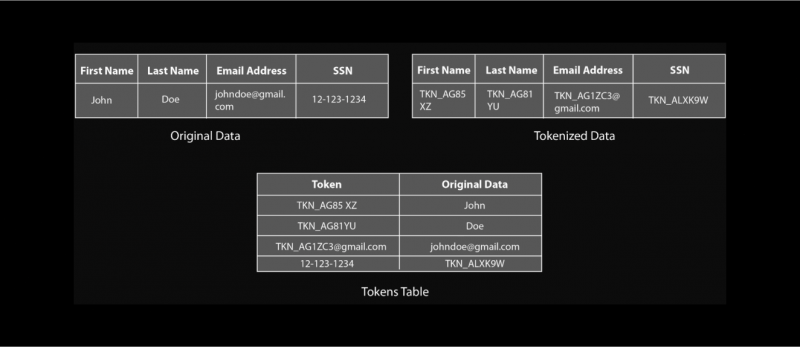

La tokenización de datos es una técnica de seguridad que reemplaza detalles sensibles con una cadena aleatoria de caracteres no reversible llamada token. Estos tokens se generan aleatoriamente y no tienen relación matemática con los datos originales, lo que los hace virtualmente imposibles de revertir. Este token actúa como un sustituto de la información original, permitiendo a las organizaciones procesarla y utilizarla sin exponer la información sensible real.

Piénselo así: Imagine su número de tarjeta de crédito como una llave de casa. La tokenización de datos crea una llave única y falsa (el token) que abre una puerta específica (representando los datos tokenizados) dentro de una bóveda segura (el sistema de tokenización). Esta llave falsa permite a los sistemas autorizados acceder a la información requerida sin exponer nunca la llave de casa original (su número de tarjeta de crédito), asegurando una mayor seguridad y privacidad.

Las empresas hoy manejan vastas cantidades de información sensible, desde números de cuenta primaria (PANs) y detalles de tarjetas de crédito hasta números de cuentas bancarias e información de identificación personal (PII). Asegurar esta información es crucial para la integridad de los datos y la confianza del cliente. La tokenización de datos ofrece una solución confiable para proteger esta información sensible al reducir su exposición y mejorar la seguridad general de los datos.

Tipos de Tokenización

Tokenización que preserva el formato (FPE) es una técnica criptográfica que encripta datos mientras preserva el formato original. Esto la hace ideal para la tokenización porque asegura que el token pueda usarse sin problemas en sistemas existentes sin requerir modificaciones.

Tokenización basada en bóveda garantiza el almacenamiento seguro de datos originales, centraliza la gestión de tokens y mejora los controles de acceso.

Tokenización sin bóveda, también conocida como tokenización que preserva el formato o tokenización determinista, implica aplicar un algoritmo a los datos sensibles para generar un token que conserva el mismo formato y longitud que el original.

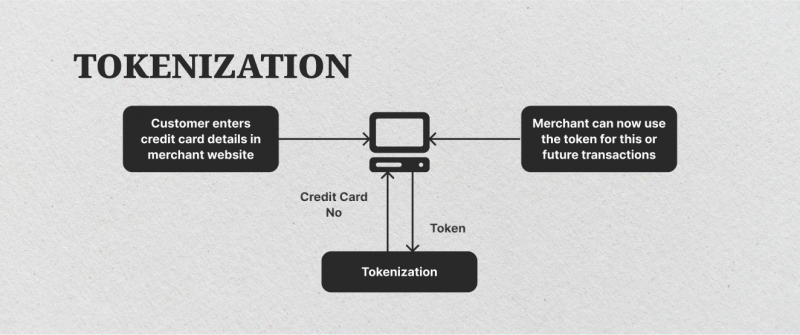

Cómo Funciona

Como se mencionó, la tokenización de datos reemplaza números sensibles con un valor de token aleatorio. Este token no tiene relación directa con la información original, volviéndolo sin sentido si es interceptado. El sistema de tokenización asigna de forma segura los tokens a los datos originales en un entorno seguro, asegurando que la información sensible permanezca protegida del acceso no autorizado.

Por ejemplo, considere el procesamiento de tarjetas de crédito en transacciones minoristas o en línea. Una solución de tokenización reemplazaría el número de tarjeta de crédito con un token durante la transacción, manteniendo el número de cuenta primaria confidencial y resguardado de posibles amenazas.

Los datos tokenizados aún pueden utilizarse dentro de sistemas internos para análisis estadísticos y procesamiento de transacciones, haciéndolo versátil sin exponer información sensible.

Dato Rápido

El concepto de tokenización fue creado en 2001 por una empresa llamada TrustCommerce para su cliente, Classmates.com, que necesitaba reducir significativamente los riesgos involucrados en almacenar datos de titulares de tarjetas.

Componentes Clave de la Tokenización

La tokenización de datos se basa en varios componentes fundamentales para generar, almacenar y gestionar tokens de forma segura. Estos componentes trabajan juntos para proteger información sensible asegurando que los tokens permanezcan seguros y que el acceso a los datos originales esté estrictamente controlado. Aquí están los elementos principales que conforman un sistema de tokenización:

Sistema de Tokenización

El sistema de tokenización es el corazón de este proceso. Genera y gestiona los tokens, reemplazando datos sensibles con valores generados aleatoriamente. Este sistema generalmente incluye algoritmos que crean tokens de manera que sean únicos y difíciles de adivinar.

También aplica políticas de seguridad, como controles de acceso y mecanismos de autenticación, asegurando que solo personal o sistemas autorizados puedan acceder a la información tokenizada. Para prevenir el acceso no autorizado, el sistema de tokenización suele estar alojado en entornos seguros, ya sea en las instalaciones o en la nube.

Bóveda de Tokens

La bóveda de tokens es una base de datos segura que almacena la asignación entre los tokens y sus datos originales correspondientes. Esta bóveda aísla la información sensible, de modo que los tokens no tienen vínculo con los datos originales a menos que se acceda a través del sistema de tokenización.

La bóveda de tokens está diseñada para estar fuertemente protegida con encriptación, firewalls y otras medidas de seguridad, ya que es el único lugar donde existe la asignación real de datos-token. El acceso a la bóveda está estrictamente controlado, y solo usuarios o sistemas con permisos especiales pueden recuperar o destokenizar la información.

Algoritmos de Tokenización

Estos algoritmos son responsables de generar los tokens que reemplazan detalles sensibles. Están diseñados específicamente para asegurar que los tokens no revelen ninguna pista sobre los datos originales. Algunos algoritmos pueden crear tokens aleatorios, mientras que otros generan tokens basados en patrones específicos (por ejemplo, preservando la longitud de un número de tarjeta de crédito).

El algoritmo elegido depende del caso de uso y los requisitos de seguridad, pero en todos los casos, el algoritmo asegura que los tokens no puedan ser revertidos o adivinados.

Control de Acceso y Autorización

El control de acceso es un componente crítico de la tokenización, asegurando que solo usuarios o aplicaciones autorizadas puedan acceder o destokenizar datos. Este control se implementa dentro del sistema de tokenización y la bóveda de tokens para gestionar permisos, hacer cumplir protocolos de autenticación y monitorear registros de acceso.

Las reglas de autorización suelen establecerse basadas en roles o niveles de seguridad, por lo que la información sensible solo es accesible para quienes la necesitan. Este componente también registra cada intento de acceso para detectar cualquier actividad no autorizada.

Gestión de Tokens y Control del Ciclo de Vida

Los tokens pueden necesitar ser actualizados, revocados o reemitidos con el tiempo, especialmente si cambian las políticas de seguridad o los requisitos de cumplimiento. La gestión de tokens abarca los procesos para manejar tokens a lo largo de su ciclo de vida, desde la creación hasta el retiro.

Por ejemplo, si un token ya no es necesario o ha sido comprometido, puede ser retirado y reemplazado con un nuevo token.

El control del ciclo de vida asegura que los tokens permanezcan seguros y que el sistema de tokenización se adhiera a los últimos estándares de seguridad, reduciendo el riesgo de exposición con el tiempo.

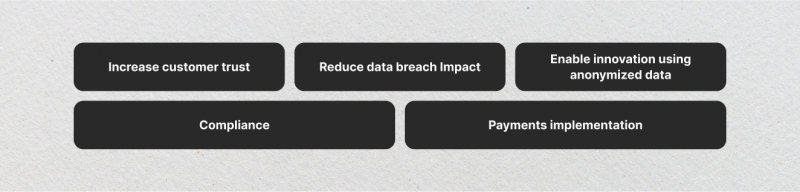

Beneficios Significativos

La tokenización de datos ofrece varias ventajas clave, convirtiéndola en una herramienta esencial para asegurar información sensible, particularmente en industrias donde la privacidad de datos y el cumplimiento regulatorio son críticos. Aquí están algunos de los principales beneficios:

Seguridad Mejorada

La tokenización de datos reduce significativamente el riesgo de brechas de datos al reemplazar información sensible con tokens sin significado. Dado que los tokens no pueden ser revertidos sin el sistema de tokenización, incluso si los atacantes acceden a datos tokenizados, no pueden usarlo para extraer la información original.

Este método de aislar los datos reales de otros sistemas crea un nivel más alto de seguridad, especialmente para información estática y de alto riesgo como detalles de tarjetas de pago e identificadores personales. Al prevenir el acceso no autorizado a información sensible, la tokenización añade una capa extra de protección que puede disuadir amenazas cibernéticas y minimizar el daño potencial en caso de una brecha.

Cumplimiento Regulatorio Simplificado

La tokenización ayuda a las organizaciones a cumplir con los requisitos de leyes y regulaciones de privacidad de datos, como el Estándar de Seguridad de Datos de la Industria de Tarjetas de Pago (PCI-DSS), el Reglamento General de Protección de Datos (GDPR) y la Ley de Privacidad del Consumidor de California (CCPA). Al mantener la información sensible separada de otros sistemas y almacenar solo tokens, las empresas pueden reducir el alcance de las auditorías de cumplimiento y la complejidad de los procesos de seguridad de datos.

Por ejemplo, al usar tokenización para información de tarjetas de crédito, una empresa puede limitar su exposición a los requisitos de PCI-DSS, ya que los datos tokenizados no están sujetos a los mismos requisitos regulatorios que los datos sensibles originales.

Ahorro de Costos y Eficiencia Operativa

La tokenización puede ayudar a las organizaciones a ahorrar costos en almacenamiento de datos e infraestructura de seguridad. Dado que los datos tokenizados son menos sensibles que los originales, pueden almacenarse en entornos con menos requisitos de seguridad, reduciendo la necesidad de centros de datos seguros y costosos.

Además, la tokenización reduce el alcance del cumplimiento, potencialmente disminuyendo los gastos de auditoría y otros costos asociados. Este enfoque simplificado también puede mejorar la eficiencia operativa al minimizar la necesidad de actualizaciones de seguridad frecuentes y monitoreo intensivo de recursos de información sensible.

Compartición y Colaboración

La tokenización permite el intercambio seguro de datos entre departamentos, socios o proveedores externos sin comprometer la seguridad de la información sensible. Dado que solo se comparten tokens y no los datos reales, las empresas pueden colaborar o analizar datos sin arriesgar su exposición. Por ejemplo, una organización de salud puede compartir registros de pacientes tokenizados con instituciones de investigación mientras protege la información sensible de los pacientes.

Mitigación del Riesgo de Amenazas Internas

La tokenización reduce el riesgo de amenazas internas al restringir el acceso a datos sensibles, ya que solo aquellos con autorización pueden acceder a la información original. Dado que los tokens no revelan pistas sobre los detalles reales, son inútiles si son accedidos por personal no autorizado dentro de la organización.

Esto puede ser particularmente valioso en entornos de alto riesgo donde el control de acceso es crucial para prevenir la exposición accidental o maliciosa de datos por empleados, contratistas u otros internos.

Escalabilidad para Entornos en la Nube y SaaS

La tokenización es altamente escalable y adecuada para aplicaciones basadas en la nube y Software como Servicio (SaaS), donde los datos sensibles se almacenan, procesan y transmiten frecuentemente. La tokenización protege la información sensible mientras permite que se almacene en entornos de nube públicos o híbridos, que a menudo vienen con preocupaciones adicionales de cumplimiento y seguridad.

Al tokenizar datos antes de que ingresen a la nube, las organizaciones pueden reducir riesgos y expandir de manera segura sus operaciones en entornos de nube o SaaS sin comprometer la seguridad.

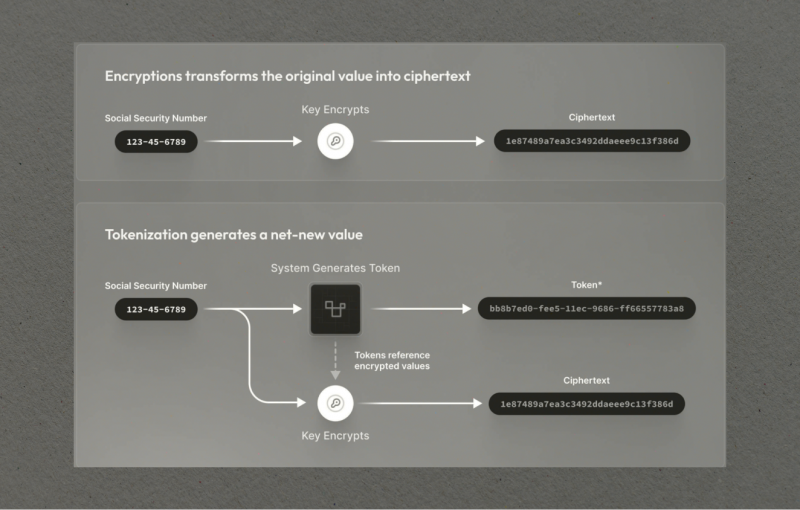

Tokenización vs. Encriptación

La tokenización de datos y la encriptación a menudo se consideran soluciones de seguridad similares. Aunque ambos métodos buscan proteger información sensible, funcionan de maneras distintas:

- Proceso: La encriptación transforma datos en un formato ilegible usando una clave criptográfica. La desencriptación requiere la misma clave para acceder a los datos originales. La tokenización, por otro lado, reemplaza detalles sensibles con un token aleatorio y no reversible.

- Reversibilidad: Los datos encriptados pueden ser desencriptados con la clave correcta, permitiendo acceso a la información original. Los tokens, por otro lado, no son reversibles. La información original solo puede accederse a través de la bóveda de tokens segura.

- Formato de Datos: La encriptación típicamente altera el formato de los datos, lo que puede afectar su usabilidad en ciertas aplicaciones. La tokenización mantiene el formato original, permitiendo una integración sin problemas con varios sistemas.

La tokenización es más adecuada para casos donde datos sensibles, como información de tarjetas de crédito, información de identificación personal (PII) o detalles de salud, necesitan ser almacenados pero no accedidos frecuentemente. Es ideal para sistemas con alto aislamiento de datos y seguridad.

La encriptación es más apropiada para escenarios donde la información necesita ser accesible o transferida de manera segura, como en comunicaciones, almacenamiento de archivos y trabajo colaborativo. La encriptación permite acceso rápido a los datos cuando se requiere, haciéndola más adecuada para entornos dinámicos.

Aunque ambos métodos pueden usarse juntos para una seguridad en capas, la tokenización proporciona mejor protección para datos estáticos y de alto riesgo, mientras que la encriptación es adecuada para casos que requieren acceso y procesamiento frecuentes.

Estableciendo Soluciones de Tokenización de Datos

Al implementar la tokenización, las organizaciones deben seleccionar la solución correcta para asegurar que cumpla con sus necesidades de seguridad específicas. Esto incluye elegir sistemas que puedan manejar generación de tokens, asignación de datos y almacenamiento seguro mientras se adhieren a las regulaciones de privacidad.

Para implementar efectivamente la tokenización de datos, las organizaciones deben considerar las siguientes mejores prácticas:

- Identificar todos los elementos de datos sensibles que requieren protección.

- Elegir una solución de tokenización confiable y segura que satisfaga las necesidades de su organización.

- Implementar una bóveda de tokens robusta para almacenar de forma segura los datos sensibles originales y las asignaciones de tokens.

- Aplicar controles de acceso estrictos para limitar el acceso a la bóveda de tokens y al sistema de tokenización.

- Realizar auditorías de seguridad regulares para identificar y abordar posibles vulnerabilidades.

- Capacitar a los empleados en las mejores prácticas de seguridad de datos y la importancia de proteger información sensible.

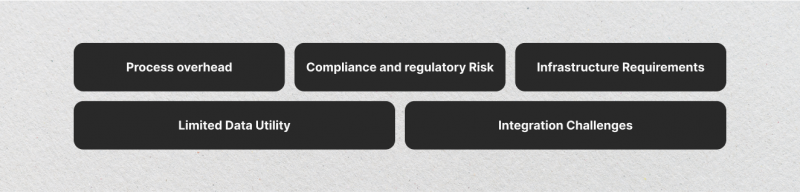

Desafíos Esperados

Aunque la tokenización de datos ofrece importantes beneficios de seguridad, también tiene ciertos desafíos y limitaciones. Comprender estas limitaciones es esencial para las organizaciones que consideran la tokenización como parte de su estrategia de protección de datos.

- Integración Compleja: Integrar un sistema de tokenización a través de varios centros de datos y sistemas internos puede ser complejo y consumir mucho tiempo.

- Costos de Mantenimiento: Mantener una solución de tokenización y asignar tokens a los datos originales requiere actualizaciones constantes y prácticas de almacenamiento seguras.

- Problemas de Integridad: Asegurar que los datos tokenizados se asignen con precisión al original sin errores es esencial, especialmente para el procesamiento de transacciones.

- Interoperabilidad Limitada con Otros Sistemas: Los datos tokenizados pueden no ser compatibles con todos los sistemas o aplicaciones, ya que muchas soluciones de software no están diseñadas para manejar tokens en lugar de datos en bruto. Integrar datos tokenizados en aplicaciones de terceros, plataformas de análisis o sistemas de socios puede ser un desafío, especialmente si estos sistemas carecen de soporte nativo para la tokenización.

- Casos de Uso Limitados para Datos Dinámicos: La tokenización es más adecuada para información estática que no necesita ser modificada o accedida con frecuencia, como números de tarjetas de crédito o PII. Para datos dinámicos que cambian a menudo, la tokenización puede ser menos efectiva, ya que cada cambio puede requerir que se genere un nuevo token, aumentando la complejidad.

En resumen, aunque la tokenización de datos proporciona protección robusta para información sensible, viene con ciertos desafíos. Las organizaciones deben considerar las posibles complejidades, costos y limitaciones de la tokenización antes de adoptarla como medida de seguridad.

Casos de Uso en Diferentes Industrias

La tokenización de datos ha encontrado amplia adopción en varias industrias:

Procesamiento de Pagos

La tokenización es una tecnología fundamental en la industria del procesamiento de pagos, donde se utiliza para proteger números de tarjetas de crédito y otra información financiera. Cuando un cliente realiza una compra, el procesador de pagos reemplaza el número de tarjeta de crédito con un token, que se utiliza para la transacción sin exponer los datos reales de la tarjeta. Esta práctica ayuda a las empresas a cumplir con los estándares PCI-DSS, que requieren medidas estrictas para proteger la información de tarjetas de pago.

Salud

En el sector de la salud, la tokenización se utiliza para asegurar información sensible de pacientes como registros médicos, números de seguros e identificadores personales. La tokenización ayuda a los proveedores de salud a cumplir con regulaciones como la Ley de Portabilidad y Responsabilidad de Seguros de Salud (HIPAA) asegurando que los datos de pacientes se almacenen y transmitan de manera segura.

Seguridad en E-commerce y Retail

Las empresas de comercio electrónico a menudo manejan grandes cantidades de datos de clientes, incluyendo detalles de pago, direcciones e información de contacto, lo que las convierte en un objetivo para ciberataques. La tokenización permite a estos negocios proteger los datos de clientes durante transacciones en línea.

Por ejemplo, cuando los clientes guardan su información de pago para futuras compras, la plataforma de comercio electrónico puede almacenar una versión tokenizada del número de tarjeta de crédito en lugar de los detalles reales de la tarjeta.

Banca y Servicios Financieros

La tokenización también se utiliza extensamente en la industria bancaria y de servicios financieros para proteger información sensible, como números de cuenta, detalles de préstamos e identificadores personales.

Esto es particularmente valioso en áreas como la banca móvil y transacciones digitales, donde los datos sensibles se transmiten frecuentemente a través de redes.

Almacenamiento en la Nube y Aplicaciones SaaS

La tokenización es cada vez más relevante en el almacenamiento en la nube y aplicaciones SaaS, donde las organizaciones almacenan y procesan datos fuera de sus propias redes seguras. Esta configuración permite a las empresas aprovechar la escalabilidad y flexibilidad de la computación en la nube sin comprometer la seguridad de los datos.

Telecomunicaciones

Las empresas de telecomunicaciones gestionan una gran cantidad de información personal, incluyendo direcciones de clientes, detalles de facturación y datos de uso. La tokenización permite a los proveedores de telecomunicaciones utilizar la información del cliente para análisis y facturación sin exponerla al acceso no autorizado.

Gobierno y Sector Público

Las agencias gubernamentales a menudo manejan grandes volúmenes de datos sensibles, incluyendo números de seguro social, información fiscal y registros personales. Por ejemplo, cuando se comparte la información de un ciudadano para propósitos administrativos, se puede utilizar una versión tokenizada de los datos para proteger la privacidad.

Industria de Seguros

La industria de seguros gestiona información personal sensible, como registros médicos, detalles financieros e historial de reclamaciones. La tokenización permite a las aseguradoras proteger los datos de los asegurados mientras procesan reclamaciones, gestionan pólizas o comparten información con proveedores externos.

Bienes Raíces y Registros de Propiedad

La tokenización se utiliza en el sector de bienes raíces para asegurar registros de propiedad, historiales de transacciones y datos de clientes. Cuando los datos de propiedad son tokenizados, solo el token es accesible, protegiendo detalles como el historial de propiedad y los montos de transacciones.

Conclusión

La tokenización de datos representa una medida de seguridad crucial para organizaciones que manejan información sensible. Su capacidad para proteger datos mientras mantiene la utilidad empresarial la convierte en una herramienta invaluable en el panorama digital actual. Al comprender e implementar la tokenización de datos, las organizaciones pueden proteger información sensible, cumplir con estándares de cumplimiento y construir una defensa resistente contra brechas de datos.

Preguntas Frecuentes

¿Qué se necesita para proteger datos sensibles?

La encriptación es un componente fundamental para proteger datos personales. Implica convertir información sensible en una forma codificada, haciéndola ilegible para cualquiera sin la clave de desencriptación adecuada.

¿Cómo funciona una solución de tokenización de datos?

La plataforma de tokenización convierte datos sensibles en elementos no sensibles llamados tokens para aumentar la protección de datos y reducir los riesgos de fraude en transacciones financieras.

¿Cuál es el proceso de tokenización de datos?

La tokenización, cuando se aplica a la seguridad de datos, es el proceso de sustituir información sensible por un equivalente no sensible, conocido como token, que no tiene significado o valor intrínseco o explotable.

¿Qué es una clave de encriptación?

Una clave de encriptación es un valor variable aplicado usando un algoritmo a una cadena o bloque de texto sin encriptar para producir o desencriptar texto cifrado.